Veröffentlicht: 06.03.2024 • Zuletzt bearbeitet: 23.06.2024

OpenAI Sora: Die Revolution in der Generierung von Videos aus Text

OpenAI stellte kürzlich seine neueste bahnbrechende Technologie vor – Sora. Dieses Text-zu-Video-generative KI-Modell sieht beeindruckend aus und birgt großes Potenzial in verschiedenen Branchen. Sehen Sie, was OpenAI’s Sora ist, wie es funktioniert, potenzielle Anwendungsfälle und einen Blick in die Zukunft.

Was ist Sora?

Sora ist OpenAIs Text-zu-Video-generative KI-Modell. Das bedeutet, dass Sie einen Texteingabe geben, und es erstellt ein Video, das der Beschreibung der Eingabe entspricht. Ein Beispiel von der OpenAI-Website:

Beispiele von OpenAI Sora

OpenAI und CEO Sam Altman teilten zahlreiche Beispiele für Sora in Aktion. Hier sind einige davon:

OpenAI Sora Animationsbeispiel

Prompt: Eine wunderschön gestaltete Papierbastelwelt eines Korallenriffs mit vielen bunten Fischen und Meeresbewohnern.

OpenAI Sora Stadtszenen-Beispiel

Prompt: In der schönen, verschneiten Stadt Tokio herrscht reges Treiben. Die Kamera bewegt sich durch die belebte Straße der Stadt und folgt mehreren Menschen, die das schöne Schneewetter genießen und an nahe gelegenen Ständen einkaufen. Wunderschöne Sakura-Blütenblätter fliegen zusammen mit Schneeflocken durch den Wind.

Prompt: New York City liegt unter Wasser wie Atlantis. Fische, Wale, Meeresschildkröten und Haie schwimmen durch die Straßen von New York.

OpenAI Sora Tier-Beispiele

Prompt: Wildlife auf der Insel Borneo am Kinabatangan River

Prompt: Eine Katze weckt ihren schlafenden Besitzer auf und verlangt Frühstück. Der Besitzer versucht, die Katze zu ignorieren, aber die Katze probiert neue Taktiken aus, und schließlich holt der Besitzer einen geheimen Vorrat an Leckereien unter dem Kopfkissen hervor, um die Katze noch ein wenig länger hinzuhalten.

Wie funktioniert OpenAI Sora?

Wie textbasierte Bildgenerierungs-KI-Modelle wie DALL·E 3, StableDiffusion und Midjourney ist OpenAI Sora ein Diffusionsmodell. Das bedeutet, dass es damit beginnt, dass jedes Frame des Videos aus statischem Rauschen besteht und maschinelles Lernen verwendet, um die Bilder allmählich in etwas zu verwandeln, das der Beschreibung in der Eingabe ähnelt. Sora-Videos können bis zu 60 Sekunden lang sein.

Lösung der zeitlichen Konsistenz

Eine Innovation von Sora besteht darin, dass es mehrere Videoframes gleichzeitig berücksichtigt, was das Problem löst, Objekte konsistent zu halten, wenn sie in und aus der Ansicht gelangen. In einem Beispielvideo fällt auf, dass die Hand des Kängurus mehrmals aus dem Bild verschwindet, und wenn sie zurückkehrt, sieht die Hand genauso aus wie zuvor.

Kombination von Diffusions- und Transformer-Modellen

Sora kombiniert die Verwendung eines Diffusionsmodells mit einer Transformer-Architektur, wie sie von GPT verwendet wird. Jack Qiao merkt an, dass „Diffusionsmodelle großartig darin sind, Textur auf niedriger Ebene zu generieren, aber schlecht in der globalen Komposition sind, während Transformers das Gegenteil sind.“ Eine GPT-ähnliche Transformer-Architektur bestimmt also das Layout der Videoframes auf hoher Ebene, während ein Diffusionsmodell die Details erstellt.

In einem technischen Artikel zur Implementierung von Sora bietet OpenAI eine hochrangige Beschreibung, wie diese Kombination funktioniert. In Diffusionsmodellen werden Bilder in kleinere rechteckige „Patches“ aufgeteilt. Für Videos sind diese Patches dreidimensional, da sie durch die Zeit fortbestehen. Patches können als das Äquivalent von „Tokens“ in großen Sprachmodellen betrachtet werden: Sie sind keine Komponente eines Satzes, sondern eine Komponente einer Gruppe von Bildern. Der Transformer-Teil des Modells organisiert die Patches, und der Diffusions-Teil des Modells generiert den Inhalt für jeden Patch.

Eine Besonderheit dieser Hybridarchitektur ist, dass im Prozess der Patch-Erstellung eine Dimensionsreduktion erfolgt, um die Berechnung nicht für jedes Pixel jedes Frames durchführen zu müssen.

Steigerung der Bildgenauigkeit mit Re-Captioning

Um die Essenz der Benutzeranforderung getreu zu erfassen, verwendet Sora eine Re-Captioning-Technik, die auch in DALL·E 3 verfügbar ist. Das bedeutet, dass GPT, bevor ein Video erstellt wird, verwendet wird, um die Benutzeranfrage neu zu schreiben und dabei viele Details hinzuzufügen. Im Wesentlichen handelt es sich um eine Form der automatischen Eingabeoptimierung.

Was sind die Einschränkungen von Sora?

OpenAI nennt mehrere Einschränkungen der aktuellen Version von Sora. Sora hat kein implizites Verständnis von Physik, daher werden „real-world“ physikalische Regeln möglicherweise nicht immer eingehalten.

Ein Beispiel dafür ist, dass das Modell keine Ursache-Wirkungs-Verständnis hat. Nach einer Explosion an einem Basketballkorb erscheint das Netz beispielsweise wieder hergestellt.

Ebenso kann die räumliche Position von Objekten unnatürlich verschoben werden. In einem Video von Wolfswelpen erscheinen Tiere spontan, und die Position der Wölfe überlappt manchmal.

Unbeantwortete Fragen zur Zuverlässigkeit

Die Zuverlässigkeit von Sora ist derzeit unklar. Alle Beispiele von OpenAI sind von sehr hoher Qualität, aber es ist unklar, wie viel Auswahl beteiligt war. Wenn bei der Verwendung von Text-zu-Bild-Werkzeugen zehn oder zwanzig Bilder erstellt werden und dann das beste ausgewählt wird, ist es unklar, wie viele Bilder das OpenAI-Team generiert hat, um die in ihrem Ankündigungsartikel gezeigten Videos zu erhalten. Wenn Hunderte oder Tausende von Videos generiert werden müssen, um ein einziges brauchbares Video zu erhalten, könnte das die Akzeptanz behindern. Um diese Frage zu beantworten, müssen wir darauf warten, bis das Tool weit verbreitet verfügbar ist.

Was sind die Anwendungsfälle von OpenAI Sora?

Sora kann verwendet werden, um Videos von Grund auf zu erstellen oder vorhandene Videos zu verlängern. Es kann auch fehlende Frames aus Videos ergänzen. Hier sind einige Schlüsselanwendungsfälle:

Social Media

Sora kann verwendet werden, um Kurzvideos für soziale Plattformen wie TikTok, Instagram Reels und YouTube Shorts zu erstellen. Besonders geeignet ist Content, der schwer oder unmöglich zu filmen ist.

Ein schönes selbst gemachtes Video zeigt die Menschen von Lagos, Nigeria, im Jahr 2056. Aufgenommen mit einer Handykamera.

Werbung und Marketing

Die Erstellung von Werbespots, Werbevideos und Produktvorführungen ist traditionell teuer. Text-zu-Video-KI-Tools wie OpenAI Sora versprechen, diesen Prozess deutlich kostengünstiger zu gestalten.

Prompt: Eine Drohnenkamera kreist um eine wunderschöne historische Kirche, die auf einem Felsvorsprung entlang der Amalfiküste erbaut wurde. Die Ansicht zeigt historische und prächtige architektonische Details und abgestufte Wege und Innenhöfe, Wellen sind zu sehen, die gegen die Felsen unten brechen, während die Ansicht den Horizont der Küstengewässer und hügeligen Landschaften der Amalfiküste Italiens überblickt, Mehrere entfernte Menschen sind zu sehen, die auf den Terrassen spazieren gehen und die dramatische Aussicht auf das Meer genießen. Das warme Licht der Nachmittagssonne verleiht der Szene ein magisches und romantisches Gefühl.

Prototyping und Konzeptvisualisierung

Auch wenn KI-Video nicht in einem Endprodukt verwendet wird, kann es hilfreich sein, Ideen schnell zu demonstrieren. Filmemacher können KI für Entwürfe von Szenen vor dem Dreh verwenden, und Designer können Videos von Produkten erstellen, bevor sie diese in großem Maßstab erstellen.

Prompt: Die animierte Szene zeigt eine Nahaufnahme eines kleinen flauschigen Monsters, das neben einer schmelzenden roten Kerze kniet. Der Kunststil ist 3D und realistisch, mit einem Schwerpunkt auf Beleuchtung und Textur. Die Stimmung des Bildes ist von Verwunderung und Neugier geprägt, da das Monster mit großen Augen und offenem Mund auf die Flamme starrt. Seine Haltung und sein Ausdruck vermitteln ein Gefühl der Unschuld und Verspieltheit, als würde es die Welt um sich herum zum ersten Mal erforschen. Die Verwendung von warmen Farben und dramatischer Beleuchtung verstärkt die gemütliche Atmosphäre des Bildes.

Synthetische Datengenerierung

Synthetische Daten werden oft für Fälle verwendet, in denen Datenschutz- oder Machbarkeitsbedenken verhindern, dass echte Daten verwendet werden. Werkzeuge wie Sora machen diesen Prozess viel billiger und zugänglicher für ein breiteres Publikum.

Synthetische Datenerzeugung für Videos bietet Vorteile in Bereichen wie Unterhaltung, Forschung, Training von KI-Modellen und mehr. Die Eingabe von Text-Prompts ermöglicht die Schaffung von Inhalten, die in der realen Welt möglicherweise schwer zu erfassen oder teuer zu produzieren sind.

Was sind die Risiken von OpenAI Sora?

Das Produkt ist neu, daher sind die Risiken noch nicht vollständig beschrieben, werden aber wahrscheinlich denen von Text-zu-Bild-Modellen ähneln.

Generierung von schädlichem Inhalt

Ohne Schutzmaßnahmen besitzt OpenAI Sora die Macht, unschönen oder unangemessenen Inhalt zu generieren, einschließlich Videos mit Gewalt, Blut, sexuell explizitem Material, abwertenden Darstellungen von Gruppen von Menschen und anderen Hass-Darstellungen.

Fehlinformation und Desinformation

Soras Fähigkeit, fantastische Szenen zu erstellen, die in der Realität nicht existieren könnten, macht es möglich, „Deepfake“-Videos zu erstellen, bei denen echte Personen oder Situationen in etwas verwandelt werden, das nicht wahr ist.

Täuschend echte, aber gefälschte KI-Videos von Politikern könnten falsche Narrative verbreiten und legitime Quellen mit Belästigung konfrontieren, um das Vertrauen in öffentliche Institutionen zu untergraben.

Vorurteile und Stereotypen

Die Ausgabe von generativen KI-Modellen hängt stark von den Trainingsdaten ab. Kulturelle Vorurteile oder Stereotypen in den Trainingsdaten können zu denselben Problemen in den resultierenden Videos führen.

Wie kann ich auf Sora zugreifen?

OpenAI Sora ist derzeit nur für „Red Team“-Forscher verfügbar, die Experten sind und damit beauftragt sind, Probleme mit dem Modell zu identifizieren. OpenAI gab noch kein Veröffentlichungsdatum für Sora für die Öffentlichkeit bekannt, es wird jedoch voraussichtlich irgendwann 2024 sein.

Was sind die Alternativen zu Sora?

Es gibt mehrere hochkarätige Alternativen zu Sora, die es Benutzern ermöglichen, Videoinhalte aus Text zu erstellen.

- Lumiere: Von Google kürzlich angekündigt, ist es derzeit als Erweiterung für das PyTorch Deep Learning Python-Framework verfügbar.

- Make-a-Video: Von Meta im Jahr 2022 angekündigt, ist es ebenfalls über eine PyTorch-Erweiterung verfügbar.

- Emu Video: Das aktuell angekündigte Text-zu-Video-Tool von Meta

- Runway Gen-2: Ein Text-zu-Video generatives KI-Tool, das derzeit auf Web und Mobilgeräten verfügbar ist.

Es gibt auch mehrere kleinere Wettbewerber, allerdings liegt deren Schwerpunkt auf dem Einsatz von Avataren, die den vorgegeben Text wiedergeben, daher sind diese KI-Avatar-Generatoren nicht direkt mit den oben genannten KI-Videogeneratoren vergleichbar.

- Veed*: Ermöglicht das Konvertieren von Text in Videos mithilfe von KI-Tools wie Text-to-Speech

- vidnoz*: Bietet einen kostenlosen Online-Text-zu-Video-KI-Generator, mit dem Sie Text schnell in professionelle Videos umwandeln können

- InVideo*: Ermöglicht es Ihnen, mithilfe von KI Text in Videos umzuwandeln, indem Sie einfach ein Textprompt eingeben. Sie können dann Ihr Video mit Funktionen wie KI-gestalteten Voiceovers, Musik und Übergängen weiter bearbeiten

Die Konkurrenz von Google und Meta

Google Lumiere

Lumiere von Google ist derzeit noch in der aktiven Entwicklung und steht der Öffentlichkeit noch nicht zur Verfügung. Googles Engagement, das Modell zu verfeinern, deutet darauf hin, dass Lumiere bald in größerem Umfang verfügbar sein wird. Nutzer, die die Fähigkeiten von Lumiere kennenlernen möchten, sollten sich über den Google AI-Forschungsblog über die neuesten Entwicklungen informieren.

Meta Emu Video und Make-a-Video

Kurz gesagt, es gibt keine öffentlichen Informationen darüber, ob Emu Video oder Make-A-Video von Meta derzeit verfügbar sind. Es gibt zwar Ankündigungen und Forschungsergebnisse zu Emu Video von Meta AI, aber keine Hinweise auf eine öffentliche Verfügbarkeit.

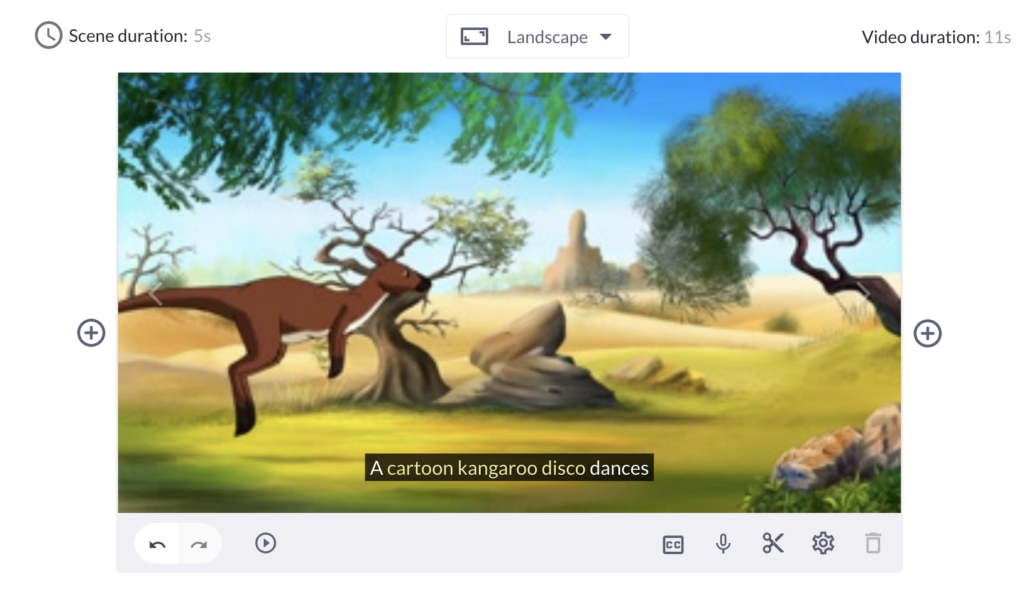

Vergleich verschiedener verfügbarer Text-to-Video-Generatoren

Ein einfacher Vergleich auf Englisch. Hier die kostenlosen Videos mit dem Prompt: „A cartoon kangaroo disco dances.“ Dies entspricht der Angabe von OpenAI für Sora. Ob dieser Prompt stimmt oder für das Sora-Video komplexer war, entzieht sich meiner Kenntnis. Was die KI der einzelnen KI-Videogeneratoren daraus macht ist schon erstaunlich, um nicht zu sagen, mehrheitlich enttäuschend.

Das Känguru von Runway Gen-2 zeigt erhebliche Fehler in der Bewegung, Vidnoz zeigt alles, nur kein Känguru, Veed lässt wenigstens Kängurus tanzen.

Hier die Ergebnisse als Video oder als Link.

OpenAI Sora:

Runway Gen-2

Hier der Link zum Ergebnis von Runway Gen-2

Veed

Vidnoz

Hier spricht ein Kommentator, aber das tanzende Disco-Kängeruh fehlt.

InVideo

InVideo greift auf iStock Fotos zurück und erfindet darum ein Story zu Kängurus und Disco-Kugeln. Eigentlich nicht schlecht, sieht man davon ab, dass es kein Zeichentrick-Känguru ist, das in der Disco tanzt.

Hier ein paar Screenshots, da meine Gratis-Credits zum Download bereits aufgebraucht sind:

Deepbrain

Deepbrain AI* setzt einen Avatar ein, der erklärt, wie Känguru tanzen lernen und gibt an, dass sie ein natürliches Gespür für Musik und Rhythmus hätten, eigentlich ganz originell.

Pictory

Hier ein Screenshot von Pictory.ai*, wie deren KI ein „A cartoon kangaroo disco dances“ sieht. Da ist zwar ein Zeichentrick-Känguru, aber es tanzt nicht in der Disco.

Was bedeutet OpenAI Sora für die Zukunft?

Es besteht kein Zweifel daran, dass Sora bahnbrechend ist. Es ist auch klar, dass das Potenzial dieses generativen Modells enorm ist. Wie wird sich Sora auf die KI-Branche und die Welt auswirken? Es lässt sich nur erahnen, aber hier sind einige Möglichkeiten, wie Sora Dinge verändern könnte, ob positiv oder negativ.

Kurzfristige Auswirkungen von OpenAI Sora

Zunächst ein Blick auf die direkten, kurzfristigen Auswirkungen, die nach einer wahrscheinlich gestaffelten Veröffentlichung für die Öffentlichkeit eintreten könnten.

- Eine Welle von schnellen Erfolgen: Potenzielle Anwendungsfälle von Sora, viele davon werden wahrscheinlich schnell übernommen, wenn Sora für die Öffentlichkeit freigegeben wird.

- Verbesserte Datenvisualisierung: Text-zu-Video generative KI könnte lebendigere Datenvisualisierungen, bessere Simulationen von Modellen und interaktive Möglichkeiten zur Erkundung und Präsentation von Daten bieten.

- Bessere Lernressourcen: Mit Tools wie Sora lassen sich Lernmaterialien erheblich verbessern. Komplexe Konzepte können zum Leben erweckt werden, während visuell orientierte Lernende, die Chance auf bessere Lernhilfsmittel erhalten.

Ein Minenfeld an Risiken

Natürlich kommt solche Technologie mit einer Vielzahl von potenziellen Risiken, und es ist unerlässlich, diese zu kennen. Hier einige der Risiken, auf die Sie achten müssen:

- Verbreitung von Desinformation und Fehlinformation: Nutzer müssen kritischer sein bei dem, was sie konsumieren, und bessere Werkzeuge benötigen, um zu erkennen, was hergestellt oder manipuliert wurde. Dies ist besonders wichtig in einem Wahljahr.

- Urheberrechtsverletzungen: Es ist darauf zu achten, wie Bilder und Abbilder verwendet werden. Gesetze und Kontrollen könnten erforderlich sein, um zu verhindern, dass persönliche Daten in nicht vereinbarter Weise verwendet werden.

- Regulatorische und ethische Herausforderungen: Die Fortschritte in der generativen KI bereiten bereits Schwierigkeiten für Regulierungsbehörden, und Sora könnte dieses Problem verschärfen.

Generatives Video wird das nächste Highlight an der Wettbewerbsfront

Wie bei ChatGPT gibt es eine ständig wachsende Liste an Alternativen, die um Positionen konkurrieren, und viele Projekte, die auf den Open-Source-LLMs aufbauen. Sora könnte das Werkzeug sein, das weiterhin Innovation und Wettbewerb auf dem Gebiet der generativen KI vorantreibt und die Mitbewerber herausfordert.

Langfristige Auswirkungen von OpenAI Sora

Nachdem sich der aufgewirbelte Staub nach der öffentlichen Einführung von OpenAI’s Sora gelegt hat, lässt sich erkennen, welche längerfristigen Auswirkungen es haben wird.

- Freischaltung von High-Value-Anwendungsfällen: Sora könnte ein unverzichtbares Werkzeug in mehreren Branchen werden, von der Erstellung von Inhalten in Marketing und Schulung über Videospiele bis hin zu traditionellen Unterhaltungsmedien wie TV und Film.

- Verschwimmen der Grenzen zwischen physischer und digitaler Welt: Sora hat das Potenzial, zu revolutionieren, wie Nutzer mit digitalen Inhalten interagieren, wenn es mit Augmented Reality (AR) und Virtual Reality (VR) kombiniert wird.

Fazit

Zusammenfassend verspricht OpenAI’s Sora-Modell einen Sprung nach vorn in der Qualität der generativen Videos. Die bevorstehende öffentliche Freigabe und ihre potenziellen Anwendungen in verschiedenen Sektoren werden mit Spannung erwartet. Im Vergleich zu den anderen Big-Playern Lumiere von Google sowie Make-a-Video und Emu Video von Meta hat OpenAI Sora mit Sicherheit die Nase vorne. Da aber alle vier Text-zu-Video-Tools noch nicht am Markt sind, bleibt dies nur eine wahrscheinliche Spekulation.

Die kleineren Mitbewerber können bei Text-zu-Video in der Qualität vielleicht nicht mithalten, aber sie punkten eindeutig bei der Avatar-Erstellung. Sie an OpenAI Sora zu messen ist wie ein Vergleich von Birnen mit Äpfeln, da sie unterschiedliche Anwendungsbereiche abdecken. Text zu Video ist eben nicht gleich Text zu Video.

Hier geht’s weiter mit KI:

Dipl.-Wirtschaftsingenieur, KI-Enthusiast, Autor

Mit 50 Jahren Erfahrung im IT-Bereich, beschäftige ich mich intensiv mit Künstlicher Intelligenz und ihren vielfältigen Anwendungen in Wirtschaft, Marketing und Alltag. Mit praxisnahen, verständlichen Beiträgen zeige ich, wie KI unseren Wandel gestaltet und wie du die Technologie sinnvoll nutzt. Für meine Arbeit erhalte ich teilweise eine kleine Aufwandsentschädigung.