Veröffentlicht: 23.04.2023 • Zuletzt bearbeitet: 09.08.2025

Sie wollen wissen, ob ein Text von einem Menschen oder einer KI stammt? Der frühere „AI Text Classifier“ von OpenAI ist offline, doch es gibt starke Alternativen. Originality.ai* führt die Erkennung deutscher Texte an – mit dem im April 2024 veröffentlichten Turbo 3.0 Modell und der aktuellen schnellen Lite-Version. Wie entwickelt sich die KI-Text-Erkennung 2025? Welche Tools setzen jetzt den Standard?

KI-Texte erkennen 2025: Die besten Tools im Überblick

Die Erkennung von KI-generierten Texten wird immer wichtiger – ob für Unternehmen, Agenturen, Lehrkräfte oder Content-Creator. Moderne Tools wie Originality.ai*, GPTZero* und copyleaks setzen 2025 neue Maßstäbe in Sachen Zuverlässigkeit, Genauigkeit und Benutzerfreundlichkeit. Wer heute wissen will, ob ein Text wirklich von einem Menschen stammt, kommt an diesen Lösungen kaum vorbei.

Der Branchenführer: Originality.ai – Lite 1.0.1

🔍 Neu: Lite 1.0.1 – eines der derzeit leistungsfähigsten KI-Erkennungsmodelle!

Im Juni 2025 stand Lite 1.0.1 in der BETA-Version bereit und ist inzwischen das Standardmodell. Es erzielt eine Erkennungsgenauigkeit von über 99 % bei führenden LLMs wie GPT-5, GPT‑4o, Gemini, Claude und DeepSeek – bei nur 0,5 % Falsch-Positiven. Auch KI-Humanizer-Tools wie Undetectable AI* erkennt es mit bis zu 99,9 % Treffergenauigkeit, selbst wenn Texte leicht bearbeitet wurden. Das Resultat: erstklassige Präzision bei minimalen Fehlalarmen.

🌍 Multilanguage-Modell: Speziell für Deutsch und internationale Inhalte Neben den spezialisierten Modellen Lite und Turbo bietet Originality.ai ein dediziertes Multilanguage-Modell, das für die Erkennung von KI-Inhalten in 30 Sprachen, einschließlich Deutsch, optimiert ist. Dieses Modell wird in der Regel automatisch aktiviert, wenn nicht-englischer Text gescannt wird, und ist darauf trainiert, sprachliche und kulturelle Nuancen zu verstehen, um eine präzise Analyse zu gewährleisten.

Leistung bei deutschen Texten laut Drittquellen Während Originality.ai selbst hohe Genauigkeitswerte angibt, liefert eine externe Benchmark-Studie, die verschiedene Detektoren vergleicht, spezifische Einblicke in die Leistung bei deutschen Texten. In diesem Test erreichte Originality.ai eine Genauigkeit von 92,5 % und eine sehr hohe Erkennungsrate (Recall) von 99,1 %. Allerdings wurde in derselben Studie auch eine höhere Falsch-Positiv-Rate von 14,1 % für deutsche Texte festgestellt. Dies deutet darauf hin, dass das Modell zwar sehr zuverlässig KI-generierte deutsche Inhalte findet, aber tendenziell auch menschliche Texte häufiger als KI einstuft als andere Modelle im selben Test. Der Benchmark-Test stammt allerdings vom Konkurrenten GPTZero vom April 2025, die sich in diesem Test selbst sehr gut bewerten und er gilt nich ausschließlich für Deutsch.

Reviews von Drittseiten

- Eine Auswertung auf Arxiv zeigt, dass Originality.ai-Modelle bei akademischen Texten eine Erkennungsrate von etwa 98 % erzielen – selbst bei technisch anspruchsvollen Inhalten.

- Laut Detecting‑AI.com liegt die Lite-Variante von Originality.ai bei 99 % Genauigkeit und unter 1 % Falsch-Positiven, was sie genauer macht als GPTZero (98 %).

- Humanoid.tools bestätigt in unabhängigen Tests: Lite erzielt etwa 98 % Genauigkeit, Turbo-Modelle über 99 %, bei False Positives < 1 % für Lite.

👉 Testen Sie Lite 1.0.1 kostenlos – für eine zuverlässige, schnelle und sichere KI-Erkennung!

Originality.ai* überzeugt mit branchenführender Erkennungsrate (über 98 %), unterstützt zahlreiche KI-Modelle wie GPT-4o, Gemini, Claude 3 und auch Grok 4 und bietet zusätzlich eine leistungsstarke Plagiatsprüfung. Das neue Turbo 3.0 Modell erkennt selbst paraphrasierte oder leicht veränderte KI-Texte – und das in 15 Sprachen. Für professionelle Nutzer gibt es eine flexible API und günstige Preise pro Wort.

Originality.ai ist allerdings weit mehr als nur ein KI-Detektor. Hier findest du einen umfangreichen Ratgeber, was das KI-Tool alles kann.

GPTZero punktet im Bildungsbereich

GPTZero* bleibt besonders im Bildungsbereich beliebt: Lehrkräfte und Hochschulen setzen auf die einfache Bedienung, transparente Analyse und die Möglichkeit, ganze Dokumente oder große Textmengen zuverlässig zu prüfen. Die neue Batch-Check-Funktion und die Integration in Lernplattformen machen GPTZero 2025 noch attraktiver.

Copyleaks nicht ganz so gut für Deutsch

copyleaks punktet mit der höchsten Erkennungsgenauigkeit in unabhängigen Tests, unterstützt über 30 Sprachen und liefert mit „AI Insights“ eine transparente Begründung für jedes Prüfergebnis. Die kostenlose Browser-Erweiterung und flexible Abo-Modelle machen Copyleaks zur ersten Wahl für viele Unternehmen und Agenturen.

Fazit:

Ganz gleich, ob Sie einzelne Blogartikel, Hausarbeiten oder große Content-Projekte prüfen wollen – mit diesen Tools sind Sie auf der sicheren Seite. Testen Sie jetzt Originality.ai*, GPTZero* oder copyleaks und sichern Sie sich die beste Erkennungsrate für KI-Texte 2025!

Warum Originality.ai – welche Vor- und Nachteile?

Vorteile

Originality.ai* gehört zu den besten Erkennungsprogrammen. Gemäß Herstellerangaben erkennt die Software Texte, die mit GPT-3, GPT-3.5, GPT-4 und auch GPT-5 generiert wurden. Lesen Sie hier weitergehende Informationen zu Originality.ai* und von ihnen durchgeführte Studien.

Neben dem Entlarven von KI führt Originality.ai* gleichzeitig einen Plagiatscheck durch. Es ist schwierig das KI-Erkennungstool auszutricksen, es erkennt auch durch KI umgeschrieben Text und solchen, dem Texter Rechtschreib- und Grammatikfehler zugefügt haben. Die Verwendung von Synonymen oder das Einfügen von Satzzeichen spürt die Software ebenfalls auf.

Hier sind einige Schlüsselfakten, die belegen, warum Originality.ai als die beste Wahl für die Erkennung von KI-generierten Texten gilt:

Hochgenaue Erkennung

- Erkennungsgenauigkeit: Originality.ai erreicht eine beeindruckende Genauigkeit von über 98% bei der Identifizierung von KI-generierten Inhalten. Diese Genauigkeit ist signifikant höher als die vieler Konkurrenzprodukte, darunter auch der „veraltete“ OpenAI Text Classifier, der in Tests nur 26% der KI-generierten Texte korrekt identifizieren konnte.

- Geringe Fehlerrate: Die Software weist eine Fehlerrate von unter 1% auf, was bedeutet, dass sie nur selten fälschlicherweise menschliche Texte als KI-generiert kennzeichnet. Dies ist besonders wichtig für Autoren und Unternehmen, die sicherstellen möchten, dass ihre Inhalte als originell anerkannt werden.

Umfassende Analyse

- Detaillierte Ergebnisse: Im Gegensatz zu anderen Tools, die nur Wahrscheinlichkeiten angeben, liefert Originality.ai präzise prozentuale Werte, die den Anteil an KI-generiertem Inhalt und Plagiaten in einem Dokument anzeigen. Dies ermöglicht eine differenzierte Analyse der Textqualität.

- Erkennung mehrerer KI-Modelle: Originality.ai kann Texte erkennen, die mit verschiedenen KI-Modellen wie GPT-2, GPT-3, ChatGPT, GPT-4o, Gemini Pro, Llama 3, Claude 3, Baidu’s Ernie und weiteren generiert wurden. Dies macht es zu einem vielseitigen Werkzeug für die Analyse moderner KI-Textgeneratoren.

Benutzerfreundlichkeit

- Intuitive Benutzeroberfläche: Die Software ist einfach zu bedienen und ermöglicht es Nutzern, schnell und effizient zu überprüfen, ob ein Text von einer KI erstellt wurde. Dies ist besonders vorteilhaft für Unternehmen und Content-Agenturen, die große Mengen an Inhalten verwalten müssen.

- Plagiaterkennung: Neben der KI-Texterkennung bietet Originality.ai auch Funktionen zur Plagiaterkennung, was es zu einem umfassenden Tool für die Sicherstellung der Textoriginalität macht.

Ist der NEUE GPT-5-Inhalt erkennbar? 🤔

OpenAI hat am 7. August GPT-5 veröffentlicht – und es als seinen „fähigsten Schreibpartner aller Zeiten“ vorgestellt.

Originality.ai hat den neuen KI-Riesen direkt auf den Prüfstand gestellt. Hier die spannendsten Ergebnisse laut Herstellerangaben 👇

✅ 99 % Erkennungsrate bei umgeschriebenen Texten

✅ 94 % bei komplett neu generierten Inhalten

📊 96,5 % Genauigkeit insgesamt

Im Test konnte GPT-5 die meisten anderen KI-Detektoren austricksen – Originality.ai erkannte jedoch 10 von 10 Textproben. Andere wie GPTZero oder Grammarly kamen kaum über 2 von 10 hinaus.

Ergebnisse im Überblick:

- Originality.ai → 10/10 ✅

- GPTZero → 1/10 ❌

- Quillbot → 2/10 ❌

- Grammarly → 2/10 ❌

- Copyleaks → 5/10 ⚖️

💡 Schreibstil-technisch kommt GPT-5 dem menschlichen Ausdruck so nah wie nie zuvor – verrät sich aber oft durch Details. Beispiel: Der Gedankenstrich „—“ tauchte in 67 % der GPT-5-Texte auf, bei menschlichen Proben jedoch in 0 %.

Fazit: GPT-5 ist mächtig, stilistisch extrem nah am Menschen – aber immer noch erkennbar.

Mehr zur vollständigen Analyse gibt’s in der Original-Studie von Originality.ai.

Erkennung von GPT-4o-Inhalten durch Originality.ai

Die Untersuchung von Originality.ai* zeigt, dass Inhalte, die von GPT-4o generiert wurden, mit einer Genauigkeit von 96,3 % vom Modell 2.0 Standard und 97,8 % vom Modell 3.0 Turbo erkannt werden können. Dies ist eine geringfügige Abnahme im Vergleich zu über 99 % Erkennungsrate bei GPT-4, die voraussichtlich verbessert wird, sobald die AI-Detektoren auf GPT-4o-Inhalte trainiert sind.

Datensatz: Für die Bewertung der Erkennbarkeit von GPT-4o-Inhalten wurde ein Datensatz von 1000 GPT-4o-generierten Textproben verwendet, bestehend aus:

- Umgeschriebene Eingabeaufforderungen (450 Proben)

- Umgeschriebene menschlich verfasste Texte (325 Proben)

- Von Grund auf neu geschriebene Artikel (225 Proben)

Evaluierung: Zur Bewertung wurde ein Open-Source-AI-Erkennungswerkzeug verwendet, das verschiedene Metriken wie Sensitivität, Spezifität, Genauigkeit und F1-Score ausgibt. Die Ergebnisse zeigen hohe Erkennungsraten der beiden Modelle:

- Modell 2.0 Standard: Recall (True Positive Rate) = 96,4 %

- Modell 3.0 Turbo: Recall (True Positive Rate) = 97,8 %

Weitere Details zu den Metriken und deren Berechnung finden sich im Originality.ai* Blogbeitrag zur Bewertung von AI-Detektoren.

Gemini KI Erkennung durch Originality.ai

In ihrer neuesten Studie untersuchte Originality.ai* das Google Bard Gemini Pro-Modell und die Fähigkeit des Originality.AI-Detektors, die Inhalte effektiv zu erkennen. Hier ihre Ergebnisse:

- Originality.AI erreichte eine beeindruckende 99,0 %ige True-Positive-Rate bei der Erkennung von Gemini Pro-Inhalten.

- Eine vergleichende Analyse mit GPTZero ergab eine 93,1 %ige True-Positive-Rate für die Erkennung von Gemini Pro.

Die Erkennbarkeit von Google Bard Gemini Pro stimmt mit anderen Sprachmodellen wie ChatGPT überein und Originality.ai* kann den Inhalt effektiv erkennen. Originality übertraf im Test GPTZero bei der KI-Erkennung und schnitt bei der Erkennung menschlicher Inhalte leicht schlechter ab.

Erfahrung: Originality.ai bei Women’s Health Interactive

Alison Huff, Chefredakteurin bei Women’s Health Interactive, setzt Originality.ai* ein, um die Genauigkeit und Authentizität ihrer Website-Inhalte sicherzustellen. Das Tool wurde gewählt, um Plagiate und KI-Einflüsse in medizinischen und Produktbewertungen zu verhindern. Die Integration war problemlos, und Ergebnisse zeigen, dass Artikel, wie „The Best Vibrating Panties“ (beste vibrierende Höschen), nach der Nutzung von Originality.AI 100 % plagiatsfrei sind. Alle Artikel durchlaufen nun vor der Veröffentlichung eine Prüfung mit dem Tool, um die Integrität der Inhalte zu bewahren. Alisons Erfahrungen bieten wertvolle Einblicke für Online-Publisher im Umgang mit KI im Content-Bereich.

Women’s Health Interactive ist ein leidenschaftliches Team von sexpositiven Autoren, investigativen Forschern und Branchenexperten, die sich für offene, ehrliche und furchtlose Gespräche über Sex, sexuelle Gesundheit und Beziehungen einsetzen. Insbesondere bei medizinischen und Produktbewertungen müssen ihre Inhalte frei von KI-Einflüssen und Plagiaten sein, um die Ehrlichkeit menschlicher Erfahrungen zu gewährleisten. Hier der Original-Artikel.

Nachteile von Originality.ai

Es gibt einige bekannte Fälle, in denen Originality.ai fälschlicherweise menschlich geschriebene Inhalte als KI-generiert erkannt hat (sogenannte „False Positives“):

Nutzung von Schreibhilfe-Tools

Die Verwendung von Tools wie Grammarly, ChatGPT, Quillbot oder Microsoft Word Editor kann den KI-Anteil-Score von Originality.ai erhöhen, auch wenn der Inhalt letztendlich von einem Menschen geschrieben wurde. Selbst wenn der Inhalt umformuliert oder nur leicht bearbeitet wird, kann dies zu einem falsch positiven Ergebnis führen.

Kurze Inhalte und formelhafte Texte

Originality.ai hat Schwierigkeiten mit sehr kurzen Inhalten oder formelhaften Texten wie Einleitungen, Schlussfolgerungen, Rezepte oder Literaturverzeichnisse. Diese Textarten können fälschlicherweise als KI-generiert erkannt werden.

Akademische Inhalte

Originality.ai ist nicht optimal für die Analyse akademischer Texte geeignet. Aufgrund des formelhaften Stils und der häufigen Nutzung von Schreibhilfen in der akademischen Welt, kann es hier vermehrt zu False Positives kommen. Originality.ai selbst rät davon ab, das Tool für Studentenarbeiten zu verwenden.

Geringe Genauigkeit bei älteren Versionen

In frühen Versionen von Originality.ai lag die Fehlerquote bei False Positives noch deutlich höher. Erst mit neueren Modellen wie Version 2.0.1 Standard konnte die Genauigkeit auf über 99% mit einer False Positive Rate unter 2% gesteigert werden.Insgesamt ist Originality.ai ein leistungsfähiges Tool, das aber nicht perfekt ist. Vor allem bei kurzen, formelhaften oder akademischen Texten sowie bei Verwendung von Schreibhilfen kann es zu Fehleinschätzungen kommen. Die Entwickler arbeiten kontinuierlich an der Verbesserung der Erkennungsgenauigkeit.

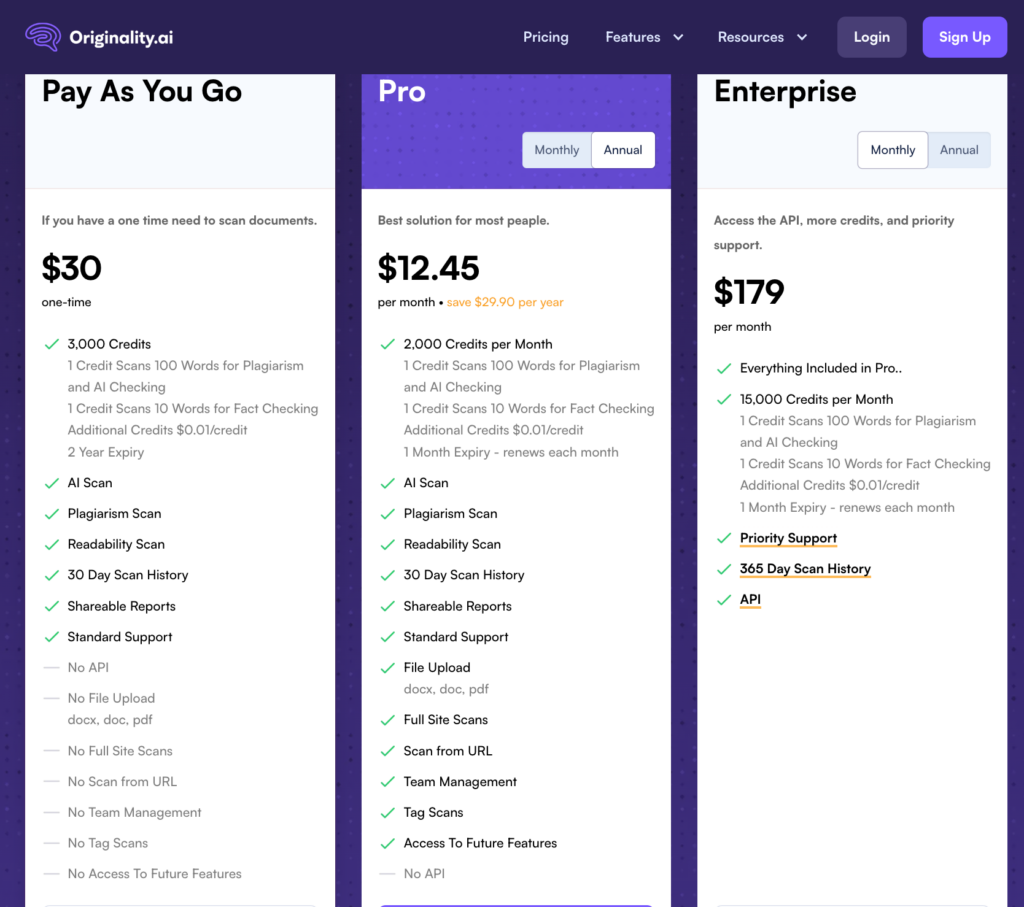

Kosten

Allerdings ist das übersichtliche Tool zum KI Texte erkennen nicht gratis. Dafür gibt es zusätzlich eine API. Die Bezahlung erfolgt über Credits. Ein Credit kostet 0,01 US$ und reicht für 100 Wörter KI-Testung oder Plagiatsprüfung. Für einen Text von 1.000 Wörtern müssen Sie für KI-Erkennung und Plagiatscheck rund 0,20 US$ hinblättern.

Starke Alternativen zu Originality.ai

In Zeiten, in denen KI-gestützter Content immer besser wird, brauchst du Tools, die wie Originality.ai einiges bieten. Zwei besonders starke Alternativen stechen hervor:

- GPTZero

Ein schlanker, intuitiver AI-Content-Detektor, der speziell für den akademischen Bereich entwickelt wurde. GPTZero* überzeugt mit fast 98 % Erkennungsgenauigkeit bei Standard-Texten und gutem Preis-Leistungs-Verhältnis – ideal für Studierende und Lehrende - Copyleaks

Ein echter Allrounder: copyleaks kombiniert AI-Erkennung, Plagiatsprüfung, Faktencheck, Grammatik und mehr – und arbeitet äußerst genau. Besonders für Organisationen und Unternehmen ist das Tool durch seine 99 %+ Genauigkeit, Teamfunktionen und API-Integration optimal geeignet

GPTZero – im Detail

Wer riesige Textmengen überprüfen will, sollte sich für die API-Schnittstelle entscheiden.

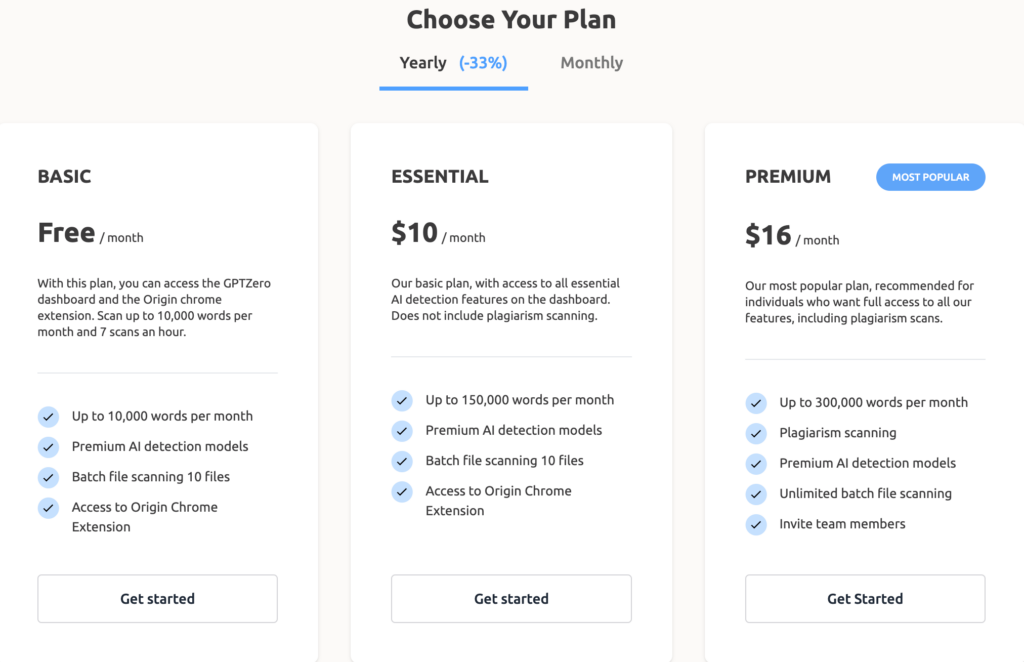

GPTZero* ist derzeit vermutlich die am meisten genutzte Software zur KI-Erkennung. Die Erkennungsrate ist recht hoch, allerdings kommt es nicht ganz an Originality.ai ran. Kleine menschliche Abänderungen im KI-Text führen schnell zu einer falschen Einschätzung. GPTZero bietet eine Chrome-Erweiterung und für Unternehmen eine API.

Das Tool gibt es als abgespeckte Variante gratis oder als Bezahlversion. Bis 5.000 Zeichen, also rund 500 bis 600 Wörter sind kostenlos, ebenso ein Add-on für Word.

Hier die Preise:

copyleaks – im Detail

Gemäß einer Studie ist der KI-Inhaltsdetektor* von CopyLeaks der genaueste LLM-generierte Textdetektor. In dieser Arbeit untersuchten die Autoren 124 Einsendungen von Informatikstudenten vor der Erstellung von ChatGPT. Anschließend liessen sie ChatGPT 40 Beiträge erstellen, um acht öffentlich verfügbare LLM-generierte Textdetektoren anhand von Genauigkeit, Fehlalarmen und Widerstandsfähigkeit zu bewerten. Die Texte waren auf Englisch, aber der AI Content Detector von copyleaks* scheint auch gut mit deutschen Texten zurechtzukommen. Probieren Sie es selbst aus, um deutsche Texte zu überprüfen müssen Sie allerdings ein Konto anlegen.

Fünf Seiten sind bei copyleaks* kostenlos. Brauchen Sie mehr Seiten, so können Sie dies als monatliches Abo bestellen. Der Preis erhöht sich bei 3.000 Seiten auf $20.82, bei 6.000 auf $34.16 und bei 12.000 auf $63.32. Das Abo lässt sich bis auf 120.000 Seiten im Monat erweitern.

Umfassender Vergleich der Top AI Text Classifier für den deutschen Markt

| Kriterium | Originality.ai | GPTZero | Copyleaks |

| Ideal für | Agenturen, SEO-Profis und Publisher mit strikten Qualitätsrichtlinien und WordPress-Workflows. | Akademiker, Studenten, Lehrer und allgemeine Nutzer, bei denen die Vermeidung von Falsch-Positiven oberste Priorität hat. | Unternehmen und Bildungseinrichtungen, die eine All-in-One-Lösung mit breiter Sprachabdeckung und integrierter Schreibhilfe suchen. |

| Gesamtgenauigkeit (laut Anbieter) | Lite-Modell: 99 %+ Genauigkeit, 0,5 % Falsch-Positiv-Rate. Turbo-Modell: 99 %+ Genauigkeit, <3 % Falsch-Positiv-Rate. | 99 % Genauigkeit bei der Unterscheidung von KI- und menschlichen Texten. Falsch-Positiv-Rate von <1 %. | 99,12 % Gesamtgenauigkeit mit einer Falsch-Positiv-Rate von unter 0,2 %. |

| Genauigkeit für Deutsch (externe Studie) | Genauigkeit: 92,5 %, Erkennungsrate: 99,1 %, Falsch-Positiv-Rate: 14,1 %. | Genauigkeit (F1-Score): 98,7 %. Falsch-Positiv-Rate: 0,0 %. | Genauigkeit: 95,0 %, Erkennungsrate: 96,0 %, Falsch-Positiv-Rate: 6,12 %. |

| Stärken & Schwächen (Genauigkeit) | Stärke: Sehr hoch bei Paraphrasierungen. Schwäche: Einige externe Tests weisen auf eine höhere Rate an Falsch-Positiven hin, insbesondere bei Deutsch. | Stärke: Sehr hohe Genauigkeit bei gleichzeitig sehr niedriger Falsch-Positiv-Rate in Benchmarks. Gilt als einer der zuverlässigsten Detektoren. | Stärke: Hohe beanspruchte Genauigkeit. Schwäche: Unabhängige Tests zeigen manchmal inkonsistente Ergebnisse oder Falsch-Positive bei menschlichen Texten. |

| Erkannte Modelle | GPT-4o, Claude 3.7, Gemini 2.5, DeepSeek V3, Llama und weitere gängige Modelle. | ChatGPT, Gemini, Llama, Claude und weitere wichtige KI-Modelle. | GPT-4, ChatGPT, Claude, Gemini, DeepSeek, Llama und weitere. |

| Stärken für den deutschen Markt | Dediziertes Multi-Language-Modell. Leistungsstarkes WordPress-Plugin. Fokus auf professionelle Publisher. | Nachgewiesen hohe Genauigkeit für Deutsch. Sehr niedrige Falsch-Positiv-Rate. Zugängliches Freemium-Modell. | Langjährige Markterfahrung. Sehr breite Sprachunterstützung (>30 Sprachen), inkl. Cross-Language-Prüfung. Bietet deutschsprachigen Schreibassistenten. |

| Preis- & Funktionsmodell | Premium-Modell, auf Profis ausgerichtet. Voller Funktionsumfang (Site Scan, Team-Tools, WP-Plugin) erst in den Abos ab ca. 15 $/Monat. | Großzügiger kostenloser Plan (10.000 Wörter/Monat). Bezahlpläne ab ca. 8 $/Monat für mehr Volumen und Premium-Features wie Plagiatsprüfung. | Credit-basiertes System. Bietet separate oder kombinierte Pläne für KI- und Plagiatsprüfung ab ca. 8-14 $/Monat. |

Zusammenfassung der Deutsch-Erkennung

Die Genauigkeit von KI-Detektoren ist bei nicht-englischen Texten generell eine größere Herausforderung. Alle drei Tools bieten jedoch Unterstützung für die deutsche Sprache mit spezifischen Leistungsdaten. Allerdings sind diese Werte immer mit gewisser Vorsicht zu genießen und dienen mehr als Anhaltspunkt, da sie von vielen Faktoren abhängen, auch von wem sie stammen.

- Originality.ai*:

- Originality.ai bietet ein dediziertes mehrsprachiges Modell („Multi Language 2.0.0“), das Deutsch unterstützt.

- Für die deutsche Sprache gibt das Unternehmen eine Genauigkeit von 98,36 % an.

- Die Falsch-Positiv-Rate (d. h. menschlicher Text wird fälschlicherweise als KI erkannt) liegt bei 1,82 %, und die Falsch-Negativ-Rate (KI-Text wird nicht erkannt) bei 1,46 %.

- Nutzer müssen bei der Überprüfung manuell das „Multi Language“-Modell auswählen, um deutsche Texte korrekt zu analysieren.

- GPTZero*:

- GPTZero hat seine mehrsprachige Unterstützung gezielt verbessert und bietet offizielle Leistungsdaten für Deutsch.

- Für deutsche Texte wird eine Genauigkeit von 98,9 % angegeben.

- Besonders hervorzuheben ist die sehr niedrige Falsch-Positiv-Rate von nur 0,62 % für Deutsch, was bedeutet, dass menschlich geschriebene deutsche Texte nur sehr selten fälschlicherweise als KI-generiert eingestuft werden.

- copyleaks:

- Copyleaks unterstützt ebenfalls die Erkennung in über 30 Sprachen, einschließlich Deutsch.

- Das Unternehmen gibt für Deutsch eine Genauigkeit von 95,63 % bei der Erkennung von KI-Texten und 99,94 % bei der korrekten Identifizierung von menschlichen Texten an.

- Aber Achtung, die primären Genauigkeitsansprüche von über 99 % basieren oft auf Tests mit englischen Datensätzen. Unabhängige Tests deuten darauf hin, dass die Genauigkeit bei bearbeiteten oder paraphrasierten Texten sinken kann.

Alle drei Tools bieten eine hohe, von den Anbietern angegebene Genauigkeit für die deutsche Sprache. GPTZero* sticht mit der niedrigsten Falsch-Positiv-Rate für Deutsch hervor, was es zu einer zuverlässigen Wahl macht, wenn die fälschliche Kennzeichnung menschlicher Texte vermieden werden soll. Originality.ai* und copyleaks bieten ebenfalls sehr hohe Genauigkeitswerte für Deutsch, wobei Originality.ai ein spezifisches mehrsprachiges Modell erfordert und die Leistung von Copyleaks in der Praxis, insbesondere bei paraphrasierten Texten, variieren kann.

Weitere KI-Erkennung-Tools zum KI Texte erkennen

Am Markt gibt es weitere KI-Detektoren, die KI Texte erkennen, teilweise sogar besser, aber nicht immer gratis oder derzeit nur als Demo-Version verfügbar:

- AI Detektor Deutsch von GhostWriter (basiert auf Originality.ai*)

- Scribbr (Englisch kostenlos, Deutsch in der Premiumversion)

- Frauenhofer Institut

- DetectGPT (derzeit keine Demoversion verfügbar)

Hier finden Sie eine alphabetisch sortierte Liste aller derzeit verfügbaren KI-Detektoren.

AI Detektor Deutsch von GhostWriter basiert auf Originality.ai

Der AI Detektor Deutsch von GhostWriter basiert auf Originality.ai*. Hier können Sie kostenlos deutsche Texte zwischen 100 und 500 Wörter auf KI testen. Das ist ideal, um kurze Artikel zu überprüfen, aber für längere Texte empfiehlt es sich bei Originality.ai* entsprechenden Credit zu kaufen.

Ich habe einen alten Artikel von mir und einen KI-Text getestet, der Detektor hat beide zu 99 % richtig erkannt. Einen überarbeiteten KI-Text erkannte er als 69 % menschlich und 31 % KI. Nicht schlecht.

Scribbr – deutsche KI Texte erkennen gegen Gebühr

Derzeit bietet Scribbr englische Texte bis 500 Wörter kostenlos zum Austesten an. Ziel ist, den KI-Anteil in folgenden Texten zu erkennen:

- Blogbeiträge

- Allgemeine Texte

- Hausarbeiten

- Bachelorarbeiten

- Masterarbeiten

Der AI-Detector von Scribbr erkennt ChatGPT3.5, GPT4 und Google Bard in Sekundenschnelle, allerdings ist nicht bekannt, auf welchem KI-Erkennungstool der AI-Detector basiert.

Frauenhofer Institut

Auch das Frauenhofer Institut SIT setzt sich mit dem Thema KI-Texterkennung auseinander. Laut ihrer Website beschreitet das Institut folgenden Weg: „Unsere textforensischen Expert*innen arbeiten dabei unter anderem mit einer selbst entwickelten Methode zur Autorschaftsverifikation, COAV: Ursprünglich wurde es genutzt, um beispielsweise Plagiate in wissenschaftlichen Arbeiten zu erkennen. Da COAV Texte auf stilistischer Basis vergleicht, lässt sich diese Methode auch für die Erkennung von einem bestimmten „Autor“ nutzen, nämlich ChatGPT.“

Das Institut weist auch auf ein Vorschlag von Forschenden der Universität Maryland hin: Watermarking for Large Language Models. Dabei geht es darum, KI-Texte mit einem Wasserzeichen zu versehen.

DetectGPT

Eric Anthony Mitchell, Informatikstudent im vierten Jahr an der kalifornischen Stanford University, befasst sich in seiner Doktorarbeit sich mit der Entwicklung einer KI-Erkennungs-Software, die zwischen von Menschen und Large Language Models (LLM) generierten Texten unterscheidet. In ersten Experimenten identifizierte das Tool die Herkunft in 95 % der Fälle bei fünf beliebten Open-Source-LLMs genau.

Das Tool befindet sich noch im Anfangsstadium, doch Mitchell hofft, es so weit verbessern zu können, dass es der Gesellschaft zugutekommt.

Mitchell und Forscher der Stanford University entwickeln derzeit eine neue Methode, um LLM-Texte sofort zu erkennen. Dieser Ansatz vermeidet das Training eines neuen Modells und verwendet einfach das LLM, das den Text wahrscheinlich generiert hat, um seine eigenen Ergebnisse zu erkennen. Das Forscherteam nimmt an, dass sich menschliche und von KI-erzeugte Texte mathematisch klar unterscheiden.

„Mag“ die LLM den Text, stammt er vermutlich aus diesem Modell. Und dies belegt eine einzige Zahl: die Wahrscheinlichkeit, dass bestimmte Wortfolgen im Modell vorkommen. Wenn nicht, stammt es nicht aus dem Modell.“ Und dieser Ansatz funktioniert laut Mitchell recht gut: „Er ist viel besser als zufälliges Raten.“

Sein Team führte einige Experimente mit AI Text Classifier, basierend auf CPT-2, durch. Bei englischen Nachrichtenartikeln funktionierte der Check gut, bei PubMed-Artikeln aus medizinischen Fachartikeln schnitt er schlecht ab und bei deutschsprachigen Nachrichtenartikeln versagte er komplett. Diese gemischten Ergebnisse sind bei vortrainierten Modellen üblich, sagt Mitchell. Im Gegensatz dazu funktionierte DetectGPT in allen drei Bereichen ohne Probleme.

DetectGPT ist leider nicht mehr als Demo verfügbar. Aber hier ist das paper dazu.

Warum KI Texte erkennen?

Hier habe ich einmal ChatGPT zu seiner Meinung befragt. Hier mein Prompt: „Nenne mir vier Gründe, warum ich KI-Texte erkennen sollte. Bitte kurz und bündig.“

- Glaubwürdigkeit: KI-generierte Texte können von menschlich verfassten Texten schwer zu unterscheiden sein. Das Erkennen von KI-Texten hilft dabei, Fehlinformationen und irreführende Inhalte zu vermeiden.

- Kritische Analyse: Die Fähigkeit, KI-Texte zu identifizieren, ermöglicht es, Informationen kritisch zu hinterfragen und fundierte Entscheidungen zu treffen, anstatt blind zu vertrauen.

- Authentizität: In einer digitalen Welt, in der Manipulation von Informationen zunimmt, hilft die Erkennung von KI-Texten dabei, die Authentizität von Inhalten zu wahren.

- Verhinderung von Plagiat: Beim Schreiben oder Recherchieren ist es wichtig, Originalität zu bewahren. Das Erkennen von KI-Texten kann verhindern, dass unbeabsichtigt auf KI-generierte Quellen zurückgegriffen wird, ohne sie angemessen zu kennzeichnen.

KI im Unterricht erlauben?

Was ChatGPT nicht erwähnt hat – gut ich wollte nur vier Gründe wissen – ist die Problematik an Schulen. Viele Lehrer sind schlicht überfordert, noch zu erkennen, was von ihren Schülern stammt und was KI dazu beigetragen hat. Aber zum Glück sorgt KI im Unterricht nicht nur für Probleme, sondern bietet auch Vorteile. Hier ein Beitrag, wie sich künstliche Intelligenz an Schulen sinnvoll einsetzen lässt und wie Schüler den richtigen Umgang damit lernen.

ChatGPT & Co an Universitäten zulassen?

Ähnlich wie an Schulen sieht es an Universitäten aus. Ging es früher darum nur Plagiate zu entlarven, kommt heute die KI-Problematik hinzu. Schließlich sollen Lehrer und Professoren die Arbeit und das Wissen von Schülern und Studenten bewerten und nicht das, was sich ChatGPT zusammenreimt. Hier braucht es klare Regeln, was erlaubt ist und was nicht, ähnlich wie früher die Nutzung eines Taschenrechners während einer Klausur. Bei schriftlichen Abschlussarbeiten wird es natürlich schwieriger den Rückgriff auf KI zu erkennen., insbesondere, wenn die Nutzung verboten ist. Besser ist eine klare Kennzeichnungspflicht, ähnlich wie jede genutzte herkömmliche Quelle.

Erkennen Suchmaschinen wie Google KI-Texte?

Ein weiterer Punkt sind Google & Co. „Nichts genaues weiß man nicht“. Straft Google KI-Texte ab oder nicht? Angeblich soll es keine Rolle spielen, wer den Text kreiert hat – solange er gut ist. Und wie sollte Google erkennen, ob der Text vom Menschen oder einer KI stammt, die Suchmaschine bräuchte einen zuverlässigen KI-Detektor. Hat Google einen?

Rechtliche Einordnung: Pflicht zur Kennzeichnung nach DSGVO und EU AI Act?

Die Frage, ob eine Kennzeichnungspflicht für KI-generierte Texte besteht, ist rechtlich vielschichtig. Die Datenschutz-Grundverordnung (DSGVO) erwähnt KI-generierte Inhalte nicht explizit. Relevant wird sie jedoch, wenn personenbezogene Daten zur Erstellung der Texte verwendet werden oder die Texte selbst solche Daten enthalten. In diesen Fällen greifen die allgemeinen Transparenzpflichten der DSGVO, die eine klare Information über die Datenverarbeitung fordern. Eine explizite Pflicht zur Kennzeichnung als „KI-Text“ ergibt sich daraus aber nicht direkt.

Deutlich konkreter wird der EU AI Act. Er sieht für bestimmte KI-Systeme, die mit Menschen interagieren, explizite Transparenzpflichten vor. So müssen Nutzer darüber informiert werden, dass sie mit einer KI interagieren. Dies gilt insbesondere für Chatbots oder andere dialogbasierte Systeme. Für die Erzeugung von sogenannten Deepfakes, also manipulierten Bild-, Ton- oder Videoinhalten, die echt erscheinen, schreibt der AI Act sogar eine zwingende Kennzeichnung vor. Für rein KI-generierte Textinhalte, wie beispielsweise Blogartikel oder Produktbeschreibungen, ist die Lage jedoch weniger eindeutig und wird von der konkreten Ausgestaltung und Anwendung des KI-Systems abhängen.

Zusammenfassend lässt sich sagen: Während die DSGVO eher indirekte Anforderungen stellt, schafft der EU AI Act eine klare Tendenz zur Kennzeichnungspflicht, die insbesondere bei interaktiven Systemen und Deepfakes greift. Eine generelle, für alle KI-Texte geltende Kennzeichnungspflicht ist aber auch im AI Act nicht verankert.

Wie kann ich selbst KI-Texten auf die Schliche kommen?

Ich habe schon zahlreiche KI-Texte von ChatGPT generieren lassen, dabei ist mir insbesondere aufgefallen, dass ChatGPT den Passiv liebt, auch wenn ich die KI im Prompt dazu auffordere aktiv zu schreiben. Die Formulierungen sind oft im Wikipedia-Stil – lieblos und wenig einfallsreich.

Es existieren bestimmte Hinweise, anhand derer man KI-Texte identifizieren kann:

- Wiederholung von Texte und Schlüsselwörtern: Falls ein Text wiederholt dieselben Schlüsselwörter oder Ausdrücke nutzt, kann dies als Anhaltspunkt für KI-Generierung dienen. KI-Systeme verwenden häufig gleiche Keywords, um die Relevanz des Textes zu einem bestimmten Thema zu erhöhen.

- Wort- oder Phrasenwahl eingeschränkt: Menschliche Texte enthalten eine größere Vielfalt an verwendeten Wörtern und Phrasen. Menschen mischen in guten Texten gerne Formal- und Umgangssprache und nutzen auch mal ein Sprichwort oder Zitat. Auch kreieren sie neue Wörter.

- Unnatürliche Syntax: KI-Systeme sind eventuell nicht in der Lage, komplexe Satzstrukturen und Grammatikregeln präzise anzuwenden. Daher können unnatürliche Formulierungen und Grammatikfehler auftreten, letztere kommen aber allerdings eher selten vor.

- Rechtschreibung: Menschen machen Fehler, die KI weniger. Das soll allerdings nicht heißen, dass Menschen diese fortan einbauen sollen, um KI zu kaschieren.

- Begrenzter Informationsgehalt: Von KI erstellte Texte erinnern mich oft an Politiker. Viel geschwätzt und nichts gesagt. Insbesondere kommt das Wort „könnte“ sehr oft vor, ChatGPT vermeidet gerne konkrete Aussagen.

- Fehlender persönlicher Stil: KI-Systeme sind nicht dazu fähig, einen individuellen Stil oder eine persönliche Stimme im Text zu entwickeln. Falls ein Text keine erkennbare persönliche Note aufweist, hat ihn mit hoher Wahrscheinlichkeit eine KI generiert.

Können Texter und Blogger KI-Texte kaschieren?

Gerade Blogger möchten nicht unbedingt, dass ihre Leser merken, dass der Text von einer KI stammt und nicht von ihnen persönlich. Da heißt es, die vorangegangenen Punkte zu beherzigen. ChatGPT & Co. sollen bei der Arbeit helfen, aber sie sollen nicht den Menschen dahinter gänzlich ersetzen.

Wie erkennen KI-Detektoren KI?

KI-Detektoren nutzen, genau wie ChatGPT und andere KI-Textgeneratoren, hochentwickelte Sprachmodelle. Um zu funktionieren, werden sie mit riesigen und vielfältigen Datensätzen trainiert, die sowohl von Menschen verfasste als auch von KI erstellte Texte enthalten. Dadurch lernen sie, die subtilen statistischen Muster zu erkennen, die beide Schreibstile voneinander unterscheiden.

Wenn ein Text analysiert wird, berechnet der Detektor im Grunde die Wahrscheinlichkeit, mit der ein menschlicher Autor oder eine KI eine bestimmte Wort- und Satzfolge gewählt hätte. Wenn die Muster stark denen ähneln, die typischerweise von KI-Generatoren erzeugt werden, schlussfolgert der Detektor, dass der Text wahrscheinlich maschinell erstellt wurde.

Dabei spielen vor allem zwei Metriken eine entscheidende Rolle:

1. Perplexität (Perplexity)

- Definition: Perplexität misst die „Verwirrung“ oder, genauer gesagt, die Vorhersehbarkeit eines Textes. Technisch ausgedrückt gibt sie an, wie gut ein Sprachmodell das nächste Wort in einer Sequenz vorhersagen kann.

- Erklärung: Ein Text mit niedriger Perplexität ist sehr vorhersagbar und wenig „verwirrend“. Er folgt den statistisch wahrscheinlichsten Wortkombinationen – ein typisches Merkmal für KI-generierte Inhalte. Ein Text mit hoher Perplexität ist hingegen unvorhersehbarer und komplexer, was eher auf einen menschlichen Autor hindeutet.

- Anwendung: KI-Textgeneratoren wählen standardmäßig Wörter, die einen Satz logisch und flüssig fortsetzen. Das Ergebnis ist oft korrekt, kann aber auch repetitiv oder formelhaft wirken. Menschliche Texte sind kreativer, nutzen unerwartete Synonyme oder Satzkonstruktionen und weisen daher eine höhere Perplexität auf.

- Beispiel: Für den Satz ‚Der Mann ging in den Laden, um…‘ gibt es plausiblere (niedrige Perplexität) und weniger plausible Möglichkeiten (hohe Perplexität), ihn zu ergänzen.

- ‚… Lebensmittel einzukaufen.‘ (Niedrige Perplexität: sehr wahrscheinliche Fortsetzung)

- ‚… einen neuen Hut zu finden.‘ (Niedrige bis mittlere Perplexität: etwas unwahrscheinlichere Fortsetzung)

- ‚… sich die neuesten Zeitungsartikel anzuschauen.‘ (Mittlere Perplexität: noch unwahrscheinlichere Fortsetzung)

- ‚… ein seltenes Insekt zu fotografieren.‘ (Hohe Perplexität: sehr unwahrscheinliche Fortsetzung)

2. Sprunghaftigkeit (Burstiness)

- Definition: Burstiness (oft als „Sprunghaftigkeit“ oder „Varianz“ übersetzt) ist ein Maß für die Variation in der Satzstruktur und -länge.

- Fragestellung: Wie stark variieren die Sätze im Text? Wechseln sich kurze, prägnante Sätze mit langen, komplexen Satzgefügen ab?

- Anwendung: Von Menschen verfasste Texte weisen typischerweise eine hohe Burstiness auf. Sie haben einen natürlichen Rhythmus, der durch die Mischung aus kurzen und langen Sätzen entsteht. KI-generierte Texte neigen hingegen zu einer sehr gleichmäßigen Satzlänge und -struktur. Dieser Mangel an Variation führt zu einer niedrigen Burstiness und lässt den Text oft monoton oder unnatürlich wirken.

Perplexität und Burstiness sind also die zentralen Indikatoren: Perplexität analysiert die Vorhersehbarkeit auf Wortebene, während Burstiness die Gleichförmigkeit auf Satzebene bewertet.

Die Grenzen der Erkennung und die Rolle von „Humanizern“

Es ist wichtig zu verstehen, dass diese Metriken statistische Indikatoren und keine endgültigen Beweise sind. Genau hier setzen sogenannte AI Humanizer oder Paraphrasing-Tools an. Diese Werkzeuge versuchen gezielt, die Perplexität und Burstiness eines KI-Textes künstlich zu erhöhen. Sie strukturieren Sätze um, variieren die Wortwahl und passen den Rhythmus an, um die statistischen Merkmale menschlichen Schreibens zu imitieren und so die Erkennung zu umgehen.

Fazit: KI-Detektoren liefern Indizien, aber keine Beweise

Derzeit ist es äußerst schwierig mit KI-Detektoren KI-Texte von vom Menschen geschriebenen Texten zu unterscheiden, aber sie werden immer besser. Die Trefferhäufigkeit ist noch nicht immer zuverlässig. Gerade Lehrer und Professoren sollten sich deshalb nicht alleine auf die Ergebnisse verlassen, denn so können schnell Fehlurteile entstehen, sie sollten immer noch andere Faktoren, wie die eigene Einschätzung hinzuziehen. Dies ist wie beim Arzt, der sich bei der Krebsdiagnose nicht alleine auf Tumormarker verlässt. Es sind handfeste Indizien, aber keine Beweise. Vielleicht sollten Lehrpläne im Bildungsbereich wieder mehr auf mündliche Prüfungen zurückgreifen.

Hier geht’s weiter mit KI:

Dipl.-Wirtschaftsingenieur, KI-Enthusiast, Autor

Mit 50 Jahren Erfahrung im IT-Bereich, beschäftige ich mich intensiv mit Künstlicher Intelligenz und ihren vielfältigen Anwendungen in Wirtschaft, Marketing und Alltag. Mit praxisnahen, verständlichen Beiträgen zeige ich, wie KI unseren Wandel gestaltet und wie du die Technologie sinnvoll nutzt. Für meine Arbeit erhalte ich teilweise eine kleine Aufwandsentschädigung.